随着人工智能技术的飞速发展,尤其是基础软件领域的突破,海内外专家开始探讨一个深刻的问题:开发具有自觉守法能力的人工智能是否可能,或者仅仅是人类的一厢情愿?这一问题触及技术、伦理和法律的交叉点,需要我们冷静分析。

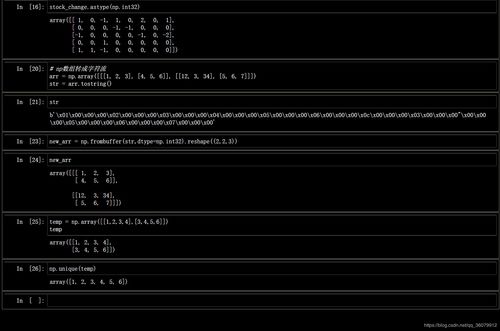

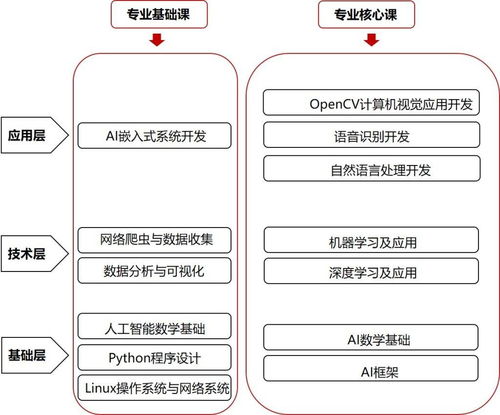

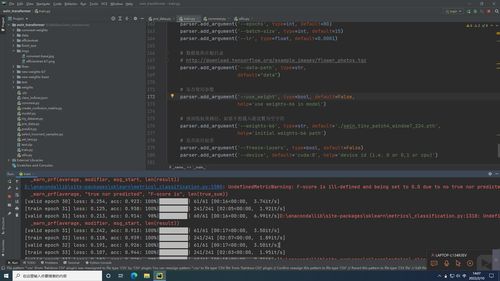

从技术层面看,人工智能基础软件的进步使得模型能够通过训练学习人类法律和道德规范。例如,机器学习算法可以从海量数据中提取法律条款的模式,并通过强化学习模拟守法行为。自觉性涉及意识和自主决策,这超出了当前弱人工智能的范畴。基础软件开发正朝着更复杂的推理能力迈进,但要实现真正的‘自觉’,还需要在认知架构上取得突破,这可能涉及强人工智能或通用人工智能的开发。

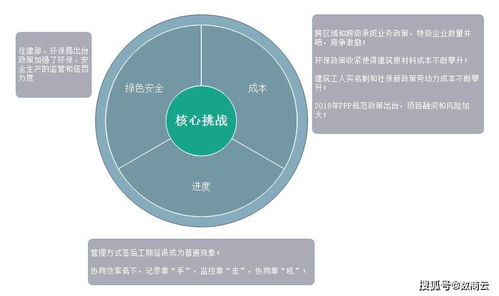

在伦理和法律方面,开发自觉守法AI的动机是明确的:它可以减少人为错误、提高社会安全,并应对诸如自动驾驶、医疗诊断等高风险场景。但这也引发了争议。一些专家认为,法律是动态的、依赖于人类价值观的,AI的‘守法’可能只是机械地执行规则,无法处理模糊情境或道德困境。海内外研究表明,过度依赖AI可能导致责任归属问题,例如当AI‘自觉’违反法律时,谁该负责?这呼唤跨学科协作,在基础软件开发中嵌入伦理框架。

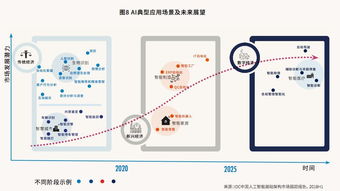

人类的一厢情愿可能体现在对AI能力的过度理想化。自觉守法不仅需要技术,还涉及社会共识和监管。基础软件如深度学习框架和算法库正变得更透明和可解释,但距离AI自主理解法律精神仍有距离。海内外项目如欧盟的AI法案和中国的AI治理倡议,都在推动标准制定,但专家警告,这需要长期努力,而非一蹴而就。

开发自觉守法的人工智能既是机遇也是挑战。基础软件开发的进步为这条路提供了可能性,但我们必须警惕技术乌托邦思维。关键在于平衡创新与监管,确保AI成为人类的辅助工具,而非替代品。海内外专家的持续对话将帮助我们在这一领域走得更远。